Ces algorithmes de machine learning soi-disant précis à 99 %

qu’il ne faut surtout pas acheter ici

Le machine learning est partout. Des applications mobiles à la maintenance industrielle, les algorithmes d’intelligence artificielle (IA) semblent capables de tout résoudre.

Mais derrière des chiffres impressionnants — comme 99 % de précision — se cachent souvent des performances bien moins spectaculaires sur le terrain.

Alors, comment évaluer correctement la qualité d’un algorithme ? Et pourquoi un score élevé ne garantit-il pas une réelle valeur métier ?

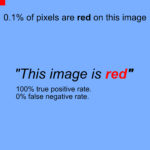

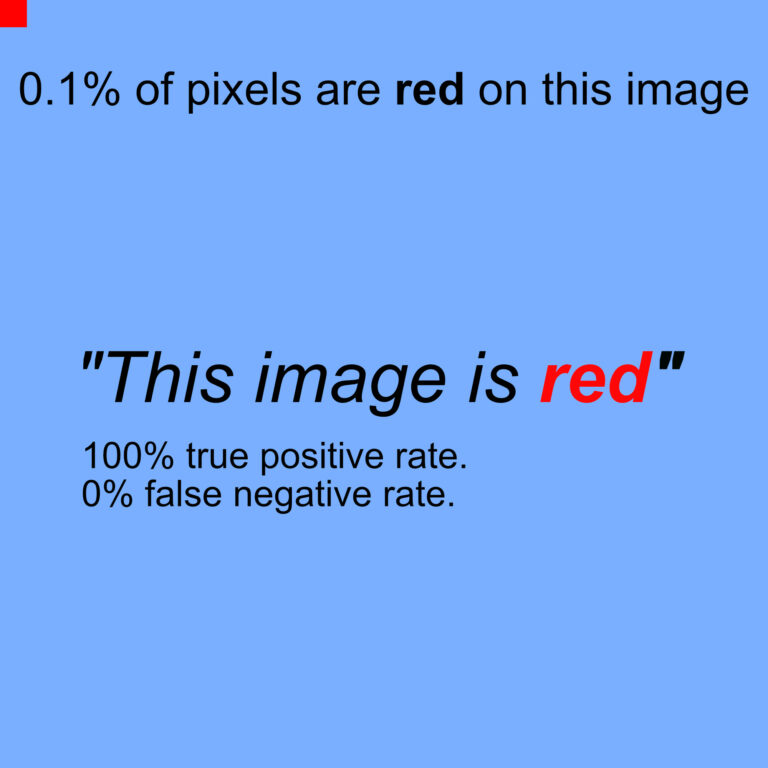

Le mythe du 99 % de précision

Lors d’appels d’offres centrés sur l’intelligence artificielle, une exigence revient souvent : « Votre algorithme doit atteindre au moins 90 % ou 99 % de précision. »

Ce chiffre, flatteur sur le papier, peut pourtant masquer une réalité inquiétante.Un algorithme peut obtenir une précision quasi parfaite tout en échouant à détecter les cas réellement importants.

L’exemple concret : la détection de défauts sur les éoliennes

Chez Cornis, nous inspectons les pales d’éoliennes depuis 2011.

En 2018, notre base contenait 4 millions d’images, dont seulement 6 000 présentaient un défaut critique , soit 0,1 % du total.

Si un algorithme « bête » prédisait simplement aucun défaut sur chaque image, il atteindrait 99,9 % de précision.

Pourtant, il ne détecterait aucun problème réel.

C’est le paradoxe de la fausse précision : un excellent score global peut cacher une catastrophe opérationnelle.

Les métriques qui comptent vraiment

Pour évaluer un algorithme, il ne suffit pas de regarder le taux de précision. Il faut étudier plusieurs indicateurs clés :

- Taux de vrais positifs (True Positive Rate) : proportion de défauts correctement détectés.

- Taux de faux négatifs (False Negative Rate) : défauts manqués.

- Taux de vrais négatifs (True Negative Rate) : images sans défaut correctement ignorées.

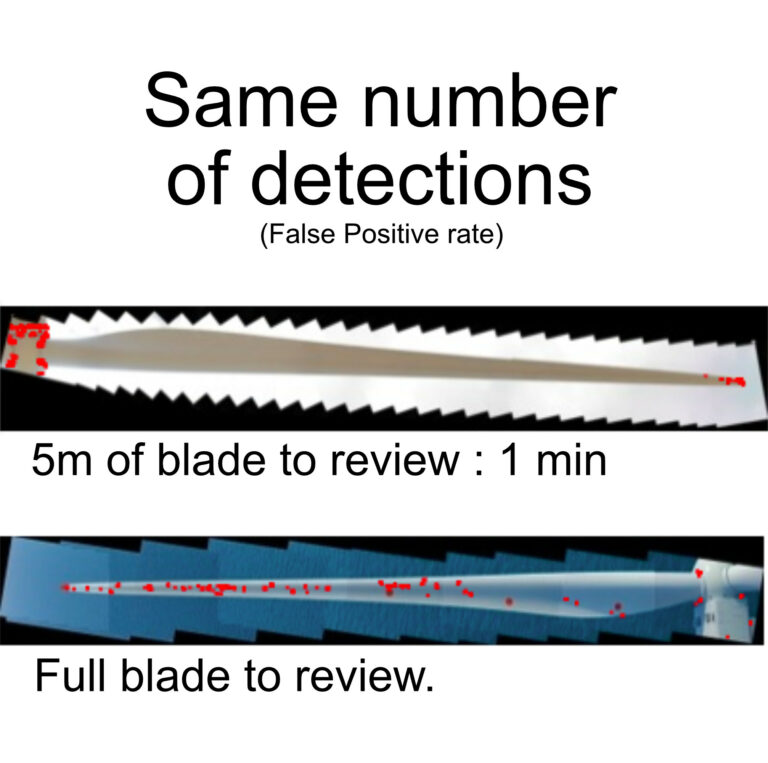

- Taux de faux positifs (False Positive Rate) : fausses alertes.

Ces quatre mesures sont indispensables pour comprendre la réalité des performances d’un modèle.

L’impact métier : au-delà des chiffres

Lors de l’analyse d’une éolienne, nous examinons environ 150 000 images.

Même avec un algorithme affichant 99 % de précision, cela représente 1 500 images à vérifier manuellement.

Le véritable indicateur de performance n’est donc pas la précision brute, mais le gain de temps réalisé lors de l’expertise.

Selon la répartition des détections, le temps d’analyse peut être divisé par deux… ou multiplié par deux.

La vraie réussite : une IA qui améliore vos processus

En 2019, Cornis a annoncé une expertise deux fois plus rapide grâce à l’IA.

Pourtant, notre algorithme n’avait rien d’un modèle à 99 % de précision.

Ce succès reposait sur un équilibre entre détection pertinente et optimisation du flux de travail.

Ne vous laissez pas séduire par un taux de précision impressionnant.

Un algorithme de machine learning n’est pas bon parce qu’il affiche un 99 %, mais parce qu’il améliore concrètement vos processus métier.

Demandez toujours plusieurs métriques et privilégiez les indicateurs de performance réels (KPI) à la simple précision statistique.